Métiers de Compliance Officer : une nécessaire évolution des compétences et des formations

Temps de lecture estimé : 6 minRédaction WEB : JUST DEEP CONTENT

Les métiers de compliance officer nécessitent des compétences nouvelles et spécifiques, auxquelles les formations doivent répondre en se spécialisant. Explications.

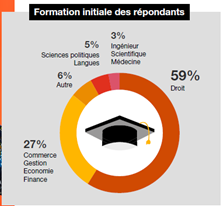

Le métier de compliance officer est aujourd’hui associé à un savoir-faire nécessitant de solides compétences juridiques et rédactionnelles, ainsi que la maîtrise du droit, de l’analyse des lois et réglementations. Généralement, le compliance officer est diplômé d’un bac +5 en droit ou école de commerce et dispose de connaissances développées des techniques de contrôles.

L’arrêté du 3 novembre 2014 impose aux entreprises une obligation légale de mise en place des dispositifs de compliance, justifiant pleinement le métier de compliance officer.

Cependant en 10 ans, le métier de compliance officer a largement évolué.

Au fur et à mesure de l’accroissement des réglementations nationales et internationales, des différentes crises bancaires telles que les subprimes ou d’autres faits marquants, le secteur bancaire a été amené à restructurer peu à peu la filière conformité, une filière dite « champignon », d’après l’observatoire des métiers.

SOMMAIRE

- Qu’est-ce que le métier de compliance officer ?

- Vers le compliance Officer 2.0 ?

- Vers une hyperspécialisation du métier de Compliance Officer en France et au-delà des frontières ?

Qu’est-ce que le métier de compliance officer ?

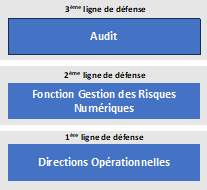

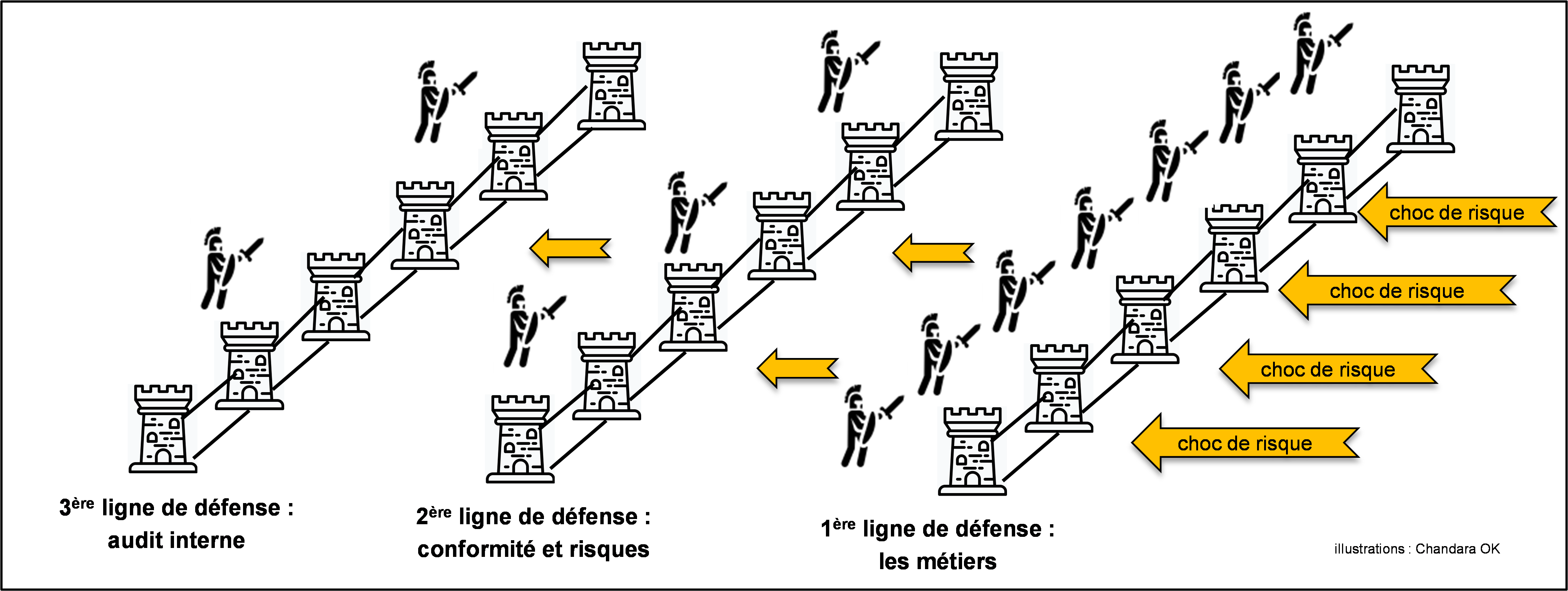

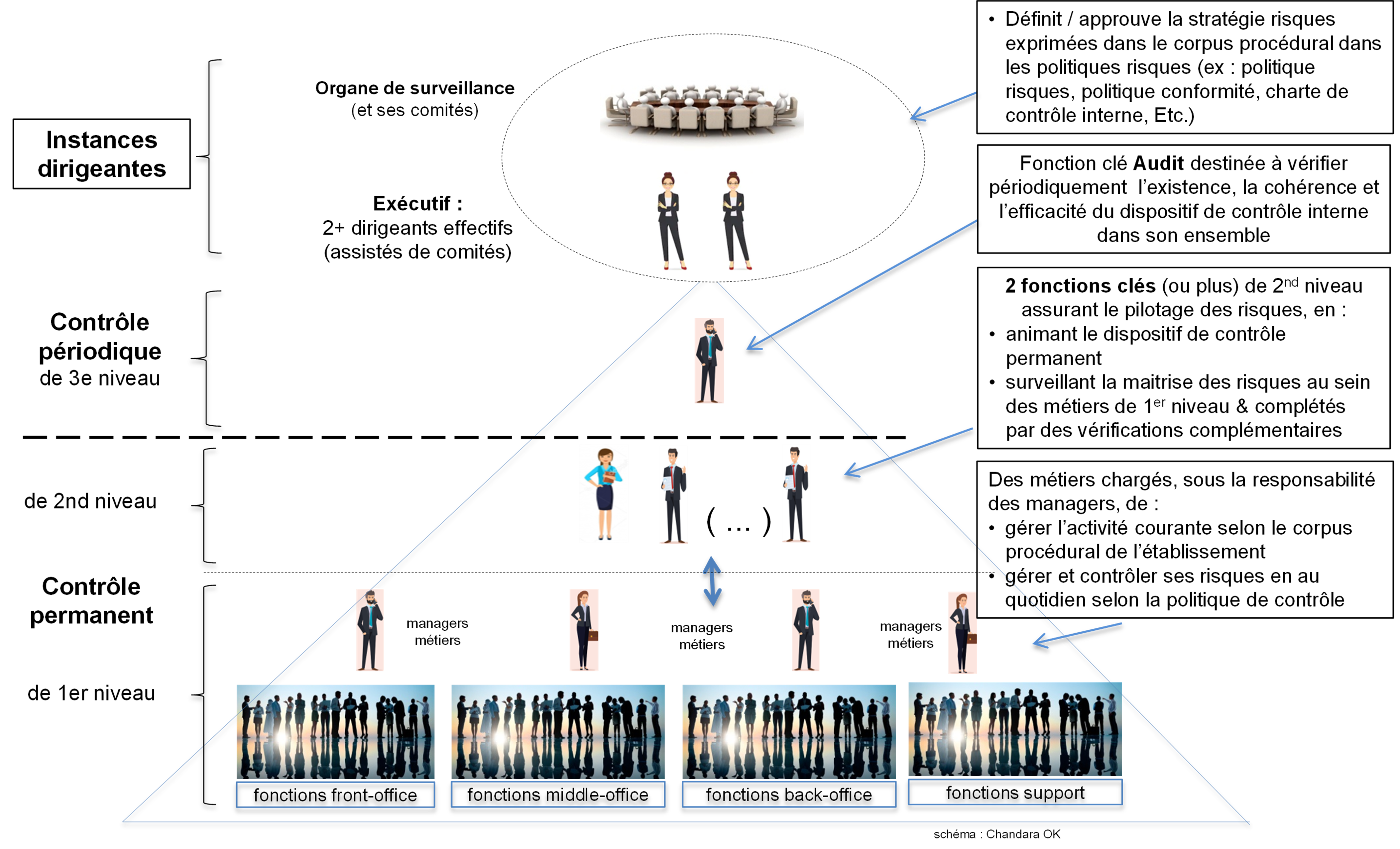

Bien établie jusque-là au cœur de la 2ème ligne de défense, le métier de la conformité répond aujourd’hui parfaitement au millefeuille réglementaire qui donne à cette fonction sa justification. La culture de l’éthique, l’exemplarité des pratiques professionnelles tendent à renforcer le partenariat avec les métiers opérationnels.

La conformité fait partie de ses filières initialement positionnées au sein des directions juridiques, et d’ailleurs initialement appelée déontologie.

Selon une étude récente, 59% des répondants à l’étude seraient issus de formations en droit.

En 2018, 35% des représentants de la fonction compliance étaient des juristes alors que 7% à 9% seulement avaient des postes de compliance officer plus ciblés tels que DPO (Délégué à la Protection des Données) par exemple.

Au fil des années et des crises systémiques, la conformité a vu son profil et son champ de responsabilité s’élargir. La conformité est donc passée d’un statut très juridique, très administratif à un positionnement davantage orienté « business partner » vis-à-vis des autres métiers.

La fonction a du très vite évolué. Longtemps occupée par des cadres dirigeants, elle a été contrainte de se rajeunir, de se diversifier dans ses apprentissages académiques, en même temps qu’elle a dû se professionnaliser.

Connaître le business, être au plus près du métier devenait un prérequis.

La fonction a peu à peu quitté les directions juridiques pour s’installer au cœur du métier de banquier. Un passage dans le monde commercial afin d’avoir une expérience opérationnelle permet d’accompagner les métiers opérationnels mais aussi de gagner en crédibilité. La conformité se doit d’accompagner les commerciaux afin de ne plus être le « mouton noir », image qu’elle avait jusqu’à présent.

Jusqu’en 2014, il existait peu d’offres de formations en conformité : quelques rares sessions en France qui mettaient en lumière le métier de chargé de conformité, très souvent associé aux formations purement juridiques.

Vers le compliance Officer 2.0 ?

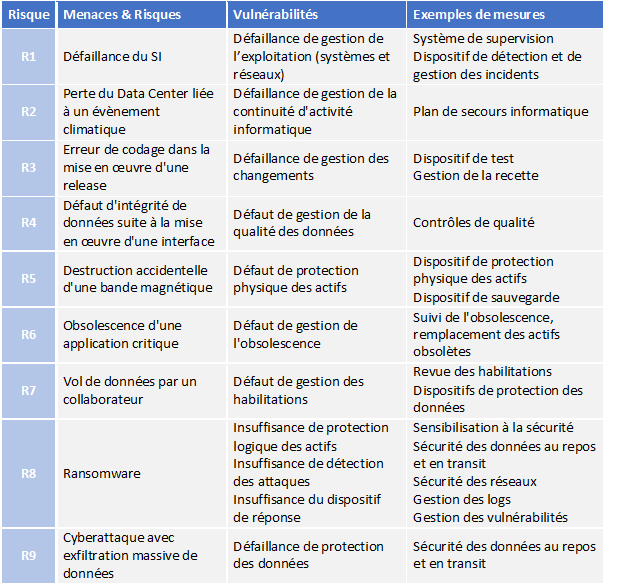

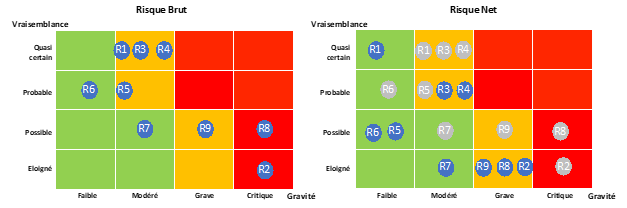

Très vite, l’évolution de la société a encouragé l’émergence de nouveaux risques financiers qu’il a fallu apprendre à maîtriser : importance grandissante des sujets sociétaux, environnementaux, mais également le développement des sujets digitaux dans le dispositif de maîtrise des risques.

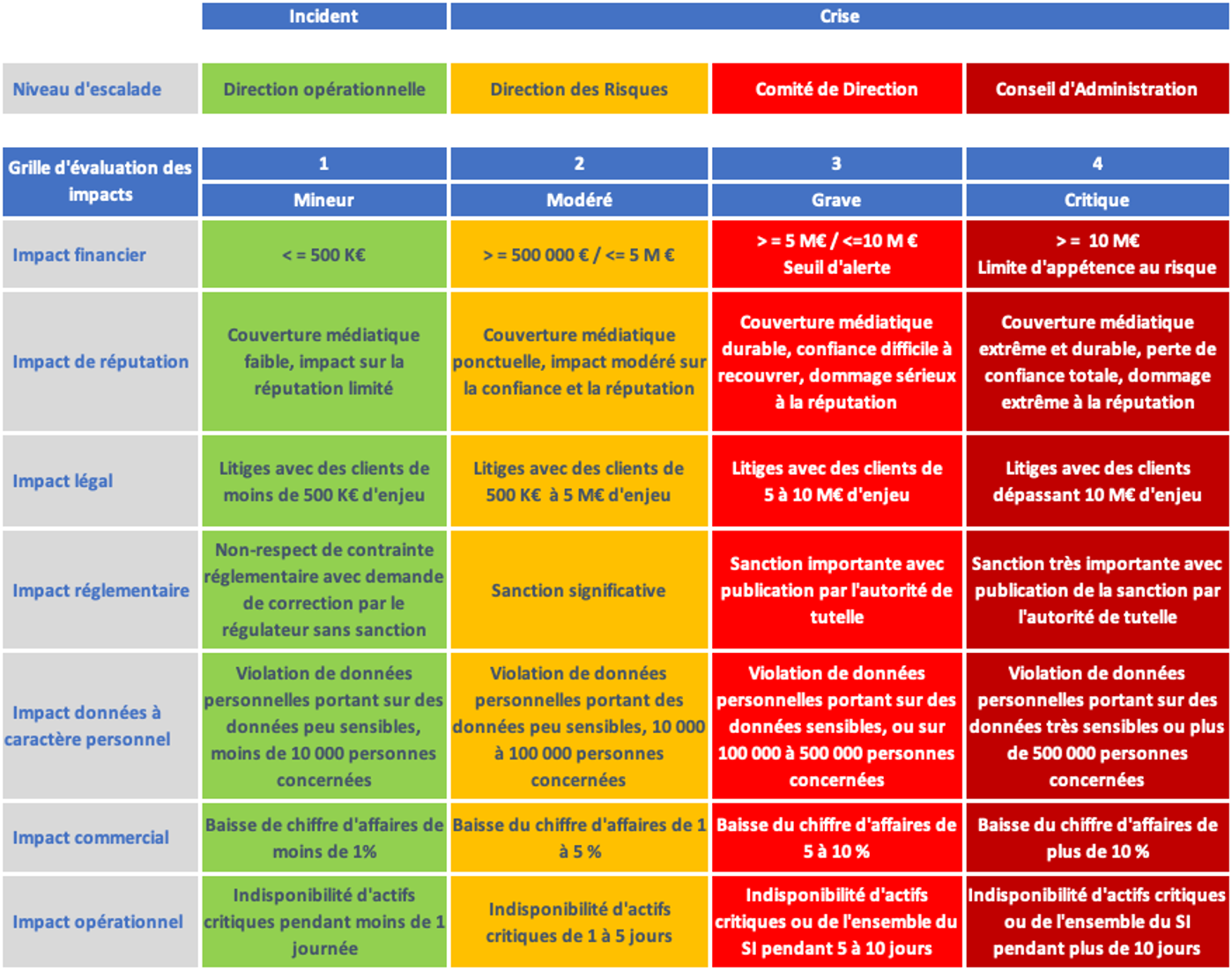

La modification des process a donné naissance à de nouveaux métiers à l’intérieur même de la compliance, en particulier dans le domaine du big data, de l’analyse des données, et des nouveaux risques tels que le RSE (Responsabilité Sociétale de l’Entreprise) par exemple..). Les compétences ont dû évoluer vers toujours plus d’expertise.

Les propositions de formations en la matière se sont également spécialisées.

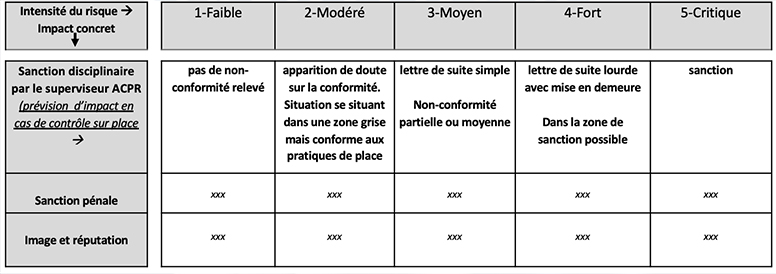

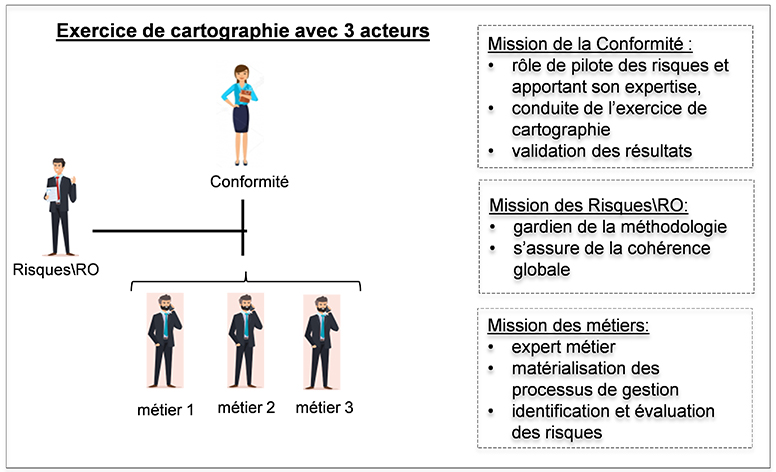

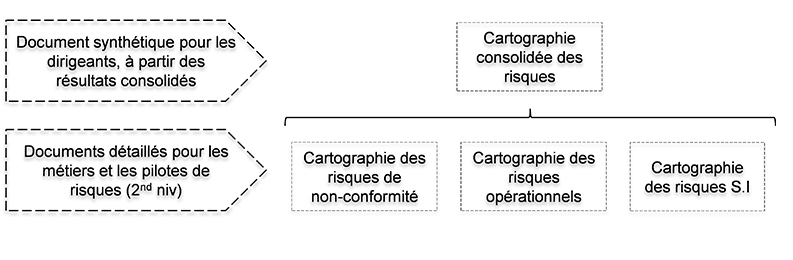

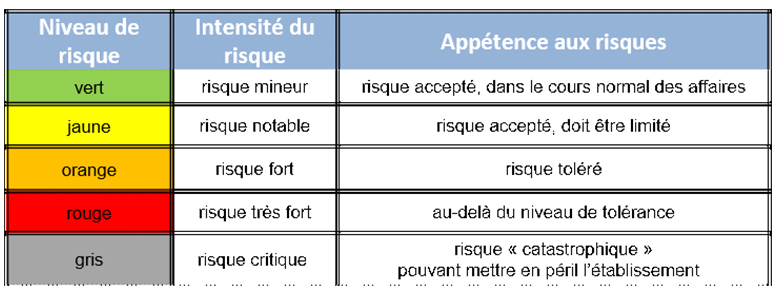

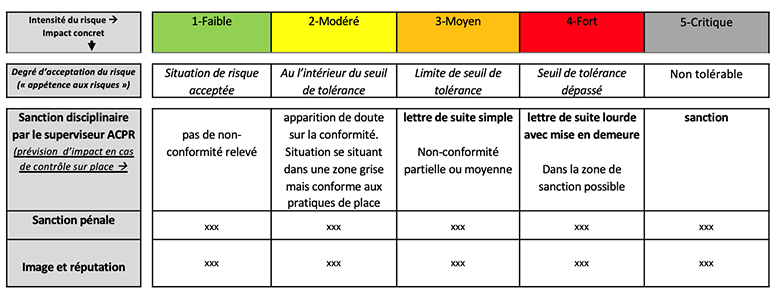

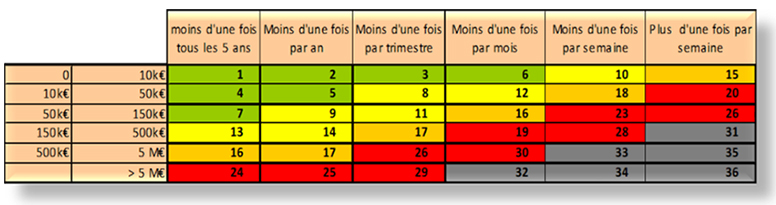

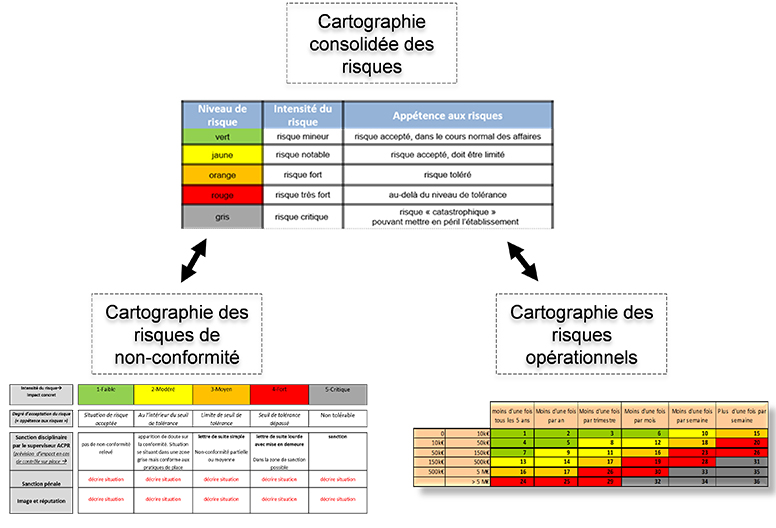

Certaines formations du métier de compliance officer allient par exemple le socle commun de la connaissance de la réglementation, permettant ensuite l’élaboration du processus conformité (définition des procédures et transposition dans les outils, élaboration de la documentation, mise en place des plans de contrôles et de la cartographie des risques…) avec la participation à des projets transverses (protection des droits et des risques clients, spécialisation sur certains domaines : conformité RSE, risques clients, conformité SI (Système d’Information)).

L’apparition de ces nouveaux métiers a fait naître de nouveaux programmes, et parfois même des partenariats entre les cursus universitaires académiques et les instituts de formations.

Beaucoup de programmes complets dédiés à la conformité ont vu le jour.

De même, les formations en interne proposent de nouveaux thèmes tels que la cybersécurité, ou les modalités de travail en mode Agile à l’attention des chargés de conformité.

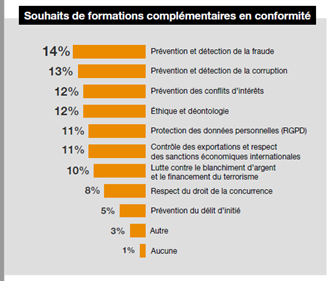

Selon une étude menée en 2021, prés de 99% des répondants (sur 135 personnes sondées) souhaitent accroître leurs compétences en suivant des formations complémentaires et ciblées dans le champ de la compliance : prévention de la fraude ou de la corruption, contrôle des exportations et respect des sanctions économiques par exemple.

Source : PWC

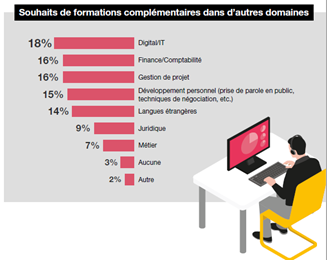

De la même façon, les mêmes répondants à cette étude indiquent souhaiter suivre une formation spécialisée dans les domaines du digital et de l’informatique, pour pouvoir accompagner la digitalisation de leur propre fonction mais également suivre les nouveaux risques numériques ou propres au secteur de la gestion de projets.

Source : PWC

Des formations dédiées ont été créées dans plusieurs universités pour former aux problématiques et aux expertises compliance : des expertises sectorielles comme les Data Protection Officers par exemple.

Il existe également des propositions de formations à l’attention de collaborateurs occupant une fonction opérationnelle, ou encore de personnes ayant un profil scientifique ou purement finance.

Dans tous les cas, l’évolution du métier de compliance officer répond à une nécessaire maîtrise des technologies digitales (analyses de données et informatiques, propositions et mises en place de scénarii sur les alertes LCB-FT, sanctions, KYC (Know Your Customer)…).

Vers une hyperspécialisation du métier de Compliance Officer en France et au-delà des frontières ?

Les évolutions sociétales, technologiques et réglementaires évoquées précédemment auront un impact significatif sur les professions de la banque.

La transformation prévue de certains fonctions, et notamment celle de compliance officer, entraînera nécessairement des changements dans la cartographie des métiers de la banque.

Les besoins en formation des collaborateurs devront être gérés. Des évolutions du contenu des métiers de la banque découle une évolution des compétences mobilisables par ces fonctions.

En Interne, le manager devra, avec les Ressources Humaines, analyser et décider comment développer l’employabilité de son équipe. Les attentes des différentes générations seront certainement fortement différenciées et la gestion des parcours de carrière devra donc être entièrement personnalisée.

En externe, certaines formations en conformité très spécialisées voient le jour en France, telles que des programmes courts ayant pour objectif de savoir comment appliquer et lier l’IA (Intelligence Artificielle) à la compliance, comprendre ses atouts pour permettre des tâches quotidiennes au sein même du département conformité, comprendre l’apport de la blockchain pour lutter contre la corruption et bien d’autres items liés à la lutte contre le terrorisme par exemple.

Au-delà de nos frontières, en Espagne par exemple,il existe des « Master de formation permanente en corporate compliance 3.0 » permettant d’approfondir des domaines innovants tels que la cybersécurité, la blockchain, le metaverse et l’IA (Intelligence Artificielle).

En Italie, un master en droit international et conformité est proposé sur 2 ans pour permettre aux apprenants d’acquérir à la fois des compétences sur les besoins du paysage commercial international actuel, du droit international mais aussi des compétences sur les scénarii de travail en fonction du pays concerné.

Enfin, aux Etats Unis, est proposé également sur 2 ans un « master of science en ligne en gestion de la criminalité financière et de la conformité ». Cette formation offre en particulier la possibilité aux apprenants d’améliorer leur expertise dans la gestion des ressources d’entreprises et technologiques pour lutter contre la criminalité financière.

On constate donc une hyperspécialisation du métier de compliance officer mais aussi le développement d’une palette de formations proposées en France et à l’international visant à répondre à l’ensemble des évolutions multifactorielles déjà évoquées dans cet article.

Parallèlement, cette hyperspécialisation peut rendre les programmes de formation rapidement obsolètes.

L’automatisation progressive des outils de contrôle et d’analyse couplée à la multiplication des réglementations peut créer actuellement une forte demande sur ces thèmes mais ne risquerait-elle pas d’être ponctuelle et s’essouffler une fois l’ensemble des processus automatisés ?

Les besoins de formation des métiers du risque et de la conformité resteront donc en évolution continue et l’offre de formation devra s’adapter en permanence.

Auteur

Chargé de conformité spécialisée – Intervenante-Formatrice pour le Cycle Expert Métiers Conformité de l’ESBanque